Wpisy od Bronisław Tumiłowicz

Mówić własnym głosem

Istnieje szansa, że ponad 136 mln osób na świecie z mową atypową zyska możliwość swobodnej komunikacji z otoczeniem

Konrad Zieliński – twórca Uhura Bionics, spółki zajmującej się praktycznymi metodami rekonstrukcji uszkodzonego głosu

Po przejściu choroby nowotworowej i zabiegu laryngektomii (usunięcia krtani) postanowił pan poszukać nowoczesnych sposobów odzyskania mowy. Pańska firma tworzy rozwiązania dla osób z mową atypową. Czym ona jest?

– Zaburzenia mowy i głosu dotykają na świecie miliony osób. Takich mówców nazywamy atypowymi. Stworzyliśmy i rozwijamy moduł AI służący do konwersji mowy – poprawiając jej zrozumienie i nadając intonację, przybliżamy osoby z mową atypową do sytuacji, w której mogą komunikować się z otoczeniem w sposób zrozumiały i swobodny. Opracowane rozwiązania proponujemy tym, którzy mają problemy z porozumiewaniem się własnym głosem z powodu czy to choroby, czy innych urazów fizycznych lub neurologicznych.

Rozwiązanie proponowane przez Uhura Bionics jest skomplikowanym urządzeniem elektronicznym wykorzystującym pewne możliwości sztucznej inteligencji. Kto stoi za jego projektem?

– Zespół Uhura Bionics jest spory i interdyscyplinarny – za projektem tego urządzenia stoi Marek Grzelec, projektant i mechatronik, który studiował m.in. na Wojskowej Akademii Technicznej. Od pięciu lat wspólnie zajmujemy się tym problemem, Uhura Bionics działa zaś od dwóch lat. W naszym interdyscyplinarnym zespole są elektronik, inżynier maszynowy i logopedka. Jako prezes odpowiadam za działalność badawczo-rozwojową, natomiast stroną technologiczną zajmuje się Marek Grzelec. Obecnie prowadzimy szeroko zakrojone badania, nawiązujemy też relacje z partnerami i wciąż budujemy zespół.

Co już teraz możecie zaoferować osobom pozbawionym możliwości swobodnego operowania swoim głosem?

– Nasze prace nakierowane są na trzy główne rozwiązania dotyczące problemów z mową. Elektroniczną krtań skonstruowano już 100 lat temu, ale od tej pory w zasadzie nie zanotowano w tej dziedzinie istotnego postępu. Przedmiotem naszych starań są dwa urządzenia: jedno prostsze i tańsze w produkcji, druga krtań – bardziej skomplikowana i dużo droższa – pozwalałaby wytworzyć głos o naturalnym brzmieniu osoby w pełni sprawnej. Oprócz tego pracujemy nad kompaktowym, eleganckim wzmacniaczem głosu oraz systemami konwersji mowy zamieniającymi głos atypowy na brzmiący bardziej zrozumiale. Odbiorcami tych urządzeń byłyby osoby dotknięte chorobami onkologicznymi lub pozbawione krtani z innych powodów.

W pana przypadku sytuacja wyglądała odmiennie, bo jeszcze przed operacją usunięcia krtani nagrał pan swój naturalny głos – stanowi on obecnie bazę do tworzenia dobrze brzmiącej mowy osobniczej. Czy przewidywał pan, że wykorzysta nagranie własnego głosu i że będzie ono przydatne w przyszłości?

– Miałem już wówczas pewne pomysły dotyczące przyszłości, zwłaszcza że w początkowej fazie choroby liczyłem na możliwość odzyskania pełnej sprawności. I tak właśnie się stało w okresie pomiędzy 2012 a 2018 r. Potem jednak nastąpił nawrót nowotworu. To wtedy nagrałem w studiu zestaw dźwięków na swoje ówczesne potrzeby. Teraz okazuje się, że nie zrobiłem wszystkiego, co byłoby mi przydatne w przyszłości. Zresztą w tym czasie nie było w Polsce dostępu do takiej usługi, tj. do zabezpieczenia głosu przez urządzenie pochodzącej z Edynburga firmy CereProc, do którego już wtedy dostęp mieli np. w Wielkiej Brytanii chorzy na chorobę Parkinsona.

Ile czasu zajęło skonstruowanie urządzenia do rekonstrukcji głosu? Czy możecie się już pochwalić seryjną produkcją, czy na razie macie jedynie prototyp?

– Pracujemy intensywnie. Posiadany kapitał umożliwił nam od 2023 do połowy 2024 r. rozpoczęcie produkcji niskoseryjnej. Powstało 60 sztuk urządzenia przeznaczonego do testowania – chcieliśmy się dowiedzieć, co należy udoskonalić w kolejnej wersji konwertera mowy. Jesteśmy obecnie w bezpośrednim kontakcie z 60 testerami: w USA – w Bostonie, gdzie tymczasowo mieszkam i jestem na wymianie doktorskiej, oraz w Polsce. Poprzez współpracujących z nami lekarzy, głównie logopedów, poszukujemy kolejnych chętnych do testowania naszego konwertera.

Jak wygląda zainteresowanie świata biznesu pańską inicjatywą?

– Na prowadzenie badań mamy porozumienia partnerskie, natomiast jeśli chodzi o produkcję urządzeń, korzystaliśmy z własnych środków spółki i dofinansowań rządowych. Stworzyliśmy konsorcjum podmiotów uniwersyteckich z krajów Unii Europejskiej: Austrii

b.tumilowicz@tygodnikprzeglad.pl

Perła renesansu trzeszczy w szwach

W 360-tysięcznej Florencji przemysł turystyczny kwitnie. I sięga po kolejne rekordy

Rzymianie budowali swoje miasta zgodnie z klasyczną tradycją na planie kwadratu. Na planach ich ulice układały się równolegle i prostopadle. Ale czasy się zmieniały. Przyszło średniowiecze, a z nim w miejsce klasycznego porządku pojawił się rozgardiasz. Plan ulic często ustalał przypadek, np. osiołek niosący na grzbiecie budulec i dobra nowego mieszkańca. Jeśli się zaparł albo coś mu stanęło na drodze, wyznaczał miejsce postoju albo krętą drogę dojścia do nowego siedliska. Takie dwa style do dziś widać na planie Florencji.

Kwitnąca turystyka, ale bez zieleni

Toskańska perła renesansu żyje głównie z turystyki. W Europie Zachodniej takie destynacje są już maksymalnie przeciążone i gdzieniegdzie mieszkańcy zaczynają się buntować, bo ich przestrzeń życiowa została brutalnie pomniejszona. Tymczasem w 360-tysięcznej Florencji przemysł turystyczny kwitnie. I sięga po kolejne rekordy. Przed pandemią COVID-19 odwiedzało ją rocznie 10 mln osób i wydawało się, że nikt więcej do tego miasta już się nie wciśnie. Tymczasem policzono, że w 2024 r. przybyło do niego 14 mln turystów i miasto ten napór wytrzymało. W związku z ostatnim Dniem Wyzwolenia, obchodzonym 25 kwietnia, i pogrzebem papieża Franciszka 26 kwietnia, we Florencji nałożyły się dni wolne – nawałnica ludzka była więc nie do wyobrażenia. Florencja trzeszczy w szwach.

Ta renesansowa perła kultury, zbudowana jeszcze za czasów rzymskich, nie utrzymała swojej pierwotnej nazwy – Florencja to znaczy kwitnąca, miasto kwiatów. Ponieważ ludziom trudno się wymawiało dwie następujące bezpośrednio po sobie spółgłoski, wybrano prostszą wersję – Firenze. Nazwa Florencja, Florence pozostała w innych językach.

Z uwagi na interesy mieszkańców miasto szybko się rozbudowywało – każdy metr gruntu był wykorzystywany, więc w starej jego części nie pozostawiono nawet skrawka zieleni. Wszystko jest tu z kamienia, a najbardziej reprezentacyjne budowle, w tym kościoły i bazyliki, mają fasady w bardzo charakterystyczny sposób obłożone czarnym i białym marmurem.

Agnieszka Pawlak, przewodniczka po mieście, mówi, wskazując na dwa trójkątne trawniki na placu przy Santa Maria Novella: – To jedyna zieleń w tej części miasta, i to całkiem na nowo uzyskana. Jeśli są tu jakieś ogrody, to tylko prywatne, wewnątrz wielkich posiadłości, na pałacowych patiach, do których zwykli ludzie nie mają dostępu. Dawni bogaci mieszkańcy budowali dla siebie siedliska o wyraźnie obronnym charakterze. Gdy jakiś intruz chciał do nich wtargnąć, sypały się na niego kamienie albo lała gorąca smoła. W mniej poważnych potyczkach spuszczano na głowy nieczystości. A ponieważ miasto nie miało kanalizacji, by nie czynić niewinnym większej szkody, każdego ranka przed wylaniem nocnika z wieży zwyczajowo wołano ostrzegawczo: „Avanti!”. To było hasło typowe właśnie dla Florencji, co tłumaczy się na nasze: do przodu, no dalej itd.

Medyceusze zwyciężali w wielu konkurencjach

Najsłynniejszym i największym zabytkiem Florencji jest katedra Santa Maria del Fiore, którą zaprojektował i zbudował rzeźbiarz i architekt Filippo Brunelleschi. Wcześniej studiował konstrukcje starożytne w Rzymie, ale by przenieść pewne metody i doświadczenia na grunt florencki, skrzętnie ukrywał swoje prace projektowe. Makiety przedstawiane komisjom konkursowym były przez ich twórcę ściśle strzeżone, wykonane z warzyw, np. marchewek, a po akceptacji zjadane przez autora.

Projektant zastosował tutaj niezwykłe jak na ówczesne czasy rozwiązania techniczne: zdecydował się na wykonanie kopuły o dwóch powłokach oraz zastąpienie kamienia w górnych partiach lżejszą cegłą. Obiekt jest monumentalny, a na niewielkim placu przed katedrą stoją jeszcze ogromne baptysterium oraz dzwonnica. Perspektywa patrzącego z bliska stwarza wrażenie, że dzwonnica przewyższa kopułę katedry, ale to typowe złudzenie optyczne. Dzwonnica ma ponad 80 m, a kopuła katedry z latarnią na szczycie – ponad 100 m i jest nie tylko najwyższą budowlą Florencji, ale przez wiele lat była najwyższą budowlą sakralną na świecie. Do dziś zachowała jedno z pierwszych miejsc w rankingu (jest czwartą największą w Europie – po Rzymie, Mediolanie i Londynie). Ogrom budowli to efekt ambicji władz Florencji, słynnego rodu Medyceuszy, którzy pragnęli zwyciężać także w konkurencji budowalnej.

Brunelleschiego można natomiast nazwać prekursorem BHP – ograniczył bowiem robotnikom picie wina, a dostawy trunku były na jego rozkaz specjalnie rozwodnione. Ponadto budowniczy pracujący na tak wysokiej budowli mieli pasy bezpieczeństwa, więc choć inwestycja trwała długie lata, tylko jeden z nich spadł z rusztowania i się zabił.

Konkurowali ze sobą także florenccy rzeźbiarze i architekci. Oprócz Brunelleschiego w historii zapisał się Lorenzo Ghilberti, który m.in. wygrał konkurs na projekt i wykonanie drzwi z brązu do baptysterium przy katedrze Santa Maria del Fiore. Utrzymanie powstałych

b.tumilowicz@tygodnikprzeglad.pl

Polski Kongres Klimatyczny: albo się zdekarbonizujesz, albo zginiesz!

Takie zdanie na zakończenie Polskiego Kongresu Klimatycznego wygłosił Jakub Safjański, dyrektor Departamentu Energii i Zmian Klimatu Konfederacji Lewiatan, patrona kongresu, organizacji skupiającej 4,1 tys. firm. Było to, jeśli wierzyć organizatorom, największe w Polsce spotkanie biznesowe dotyczące inwestycji mających wpływ na osiągnięcie celów klimatycznych. Zgromadziło wielu uczestników m.in. z sektora energetycznego, budownictwa, samorządów lokalnych itd. W ponad 20 panelach dyskusyjnych wypowiedziało się niemal 150 ekspertów z Polski i zagranicy.

Zakres poruszanych tematów obejmował: inwestycje publiczne, dekarbonizację przemysłu, tzw. zielone finanse, nową energetykę i nowe technologie. Zwrócono uwagę, że celem ogólnym działalności gospodarczej przyjętym w UE jest stopniowe zmniejszanie emisji gazów cieplarnianych, by do 2050 r. osiągnąć neutralność klimatyczną. Niezależnie od tego, czy jest to możliwe, przynajmniej dla Polski, kongres miał przygotować listę postulatów biznesu dla rządu, które należy uwzględnić w procesie przyśpieszenia zielonej transformacji polskiej gospodarki.

Trzeba jednak pamiętać, że takie hasła jak dekarbonizacja, zielona transformacja czy neutralność klimatyczna nie są powszechnie akceptowane. Jeszcze przed rozpoczęciem kongresu podważono sens wystąpień w debatach dwóch profesorów: hydrologa Piotra Kowalczaka oraz geologa Leszka Marksa, którzy mieli zabrać głos w panelu „Zmiany klimatu w historii Ziemi. Przeszłość kluczem do przyszłości”. Ich zaproszenie, a znani są z głoszenia poglądu o tzw. kłamstwie klimatycznym, nie spodobało się innym prelegentom. W prasie pojawiła się opinia: „Zapraszanie takich gości na kongres klimatyczny to mniej więcej jak zapraszanie płaskoziemców na kongres astronautyki lub antyszczepionkowców

Informatycy trzymają się mocno

Na tle krajowej nauki informatykę, w tym sztuczną inteligencję, można uznać za polską specjalność

Prof. Andrzej Jaszkiewicz – informatyk z Politechniki Poznańskiej specjalizujący się w jedno- i wielokryterialnej optymalizacji kombinatorycznej, algorytmach ewolucyjnych, sztucznej inteligencji oraz systemach wspomagania decyzji.

Czy polscy informatycy są w świecie dostrzegani, wyróżniają się poziomem przygotowania wśród specjalistów z innych krajów?

– Ta ocena jest mieszana. Nie jesteśmy szczególnie mocni w skali światowej, bo też nakłady na naukę w Polsce, wynoszące ok. 1% PKB, należą do raczej niskich w stosunku do bogatszych krajów Europy, np. Skandynawii, a także do średniej europejskiej, która wynosi ponad 2% PKB. Do czołówki się nie zaliczamy. Z drugiej strony wśród polskich naukowców w prestiżowym rankingu Uniwersytetu Stanforda oraz wydawnictwa naukowego Elsevier (Stanford/Elsevier’s Top 2% Scientist Rankings) aż ok. 9% stanowią osoby prowadzące badania w informatyce, podczas gdy w skali światowej jest to ok. 6%.

Dodajmy, że ranking jest imienny, bibliometryczny, opiera się m.in. na danych z cytowań, a wymienia ok. 1 tys. nazwisk polskich naukowców z różnych dziedzin. Informatyków jest ok. 100. Pańskie nazwisko też tam się znajduje.

– W skali naszego kraju wśród nauczycieli akademickich informatycy według danych POL-on stanowią zaledwie 3%, choć wywodzi się spośród nich 9% najlepszych polskich naukowców. Na tle krajowej nauki informatykę, w tym sztuczną inteligencję, można więc uznać za polską specjalność.

Potencjał intelektualny dostrzegamy już wśród polskiej młodzieży, bo w międzynarodowych konkursach matematycznych czy informatycznych nasi studenci odnoszą liczne sukcesy.

– Nagrody potwierdzają, że potencjał jest duży. Mamy zdolną młodzież, ale trzeba zadać pytanie, na ile jej potencjał jest wykorzystywany. Ilu wybitnie zdolnym studentom możemy zaoferować stypendia doktoranckie choć częściowo konkurencyjne wobec wynagrodzeń w przemyśle, ilu absolwentów pozostanie na uczelni i będzie przekazywało swoją wiedzę kolejnym pokoleniom, a ilu wyrwie się do firm, wspomagając największe światowe koncerny. Naszym uczelniom trudno pozyskać tych najzdolniejszych.

Tytuł magistra informatyki brzmi dumnie, ale mamy tutaj rozmaite specjalizacje. Programista stoi chyba wyżej od np. administratora?

– Informatyka to bardzo szerokie pojęcie. Zwróciłbym uwagę na jeszcze dwie „elitarne” specjalności. Jedna zajmuje się sztuczną inteligencją (AI), a druga cyberbezpieczeństwem. W praktyce informatycy obu specjalizacji tworzą opracowania w odniesieniu do konkretnych potrzeb. Obie specjalizacje są bardzo potrzebne, zwłaszcza że nieustannie tworzone są różne języki oprogramowania, wysokopoziomowe i niskopoziomowe, i coraz częściej zdarzają się zorganizowane ataki, które zagrażają cyberprzestrzeni i pochłaniają ogromne zasoby.

Warto też wspomnieć o wysokich kompetencjach potrzebnych w robotyce, gdzie wymagana jest mieszanka wiedzy z dziedziny informatyki, oprogramowania i umiejętności sprzętowych. W wielu firmach odczuwa się brak dobrze przygotowanych informatyków po studiach i tam organizuje się dodatkowe kursy i szkolenia przyuczające do zawodu. Nie są to może najwyższej klasy specjaliści, ale potrafią coś dla danej firmy stworzyć, zaprogramować pod określone potrzeby. Jednak później często się okazuje, że takie słabiej wyedukowane osoby mają większe problemy ze znalezieniem nowej pracy.

Studia informatyczne oferowane są i przez uniwersytety, i przez politechniki. Jaka jest różnica między ich absolwentami? Czy ci pierwsi są bardziej teoretykami, a drudzy praktykami?

– Absolutnie nie. Poziom kompetencji zależy raczej od jakości nauczania w konkretnej szkole wyższej. Ogólnie programy nauczania są bardzo podobne. Doszło do tego, że np. na tym kierunku na Uniwersytecie Adama Mickiewicza w Poznaniu, tak samo jak na politechnice, absolwenci otrzymują tytuł inżyniera. Poziom specjalisty w danej dziedzinie zależy od zakresu zdobytej wiedzy. Siłą rzeczy informatyk przyuczony w ciągu kilku tygodni kursu nie posiądzie takiej wiedzy jak ktoś, kto kształcił się przez kilka lat. Może się podejmować prostszych zadań, które ktoś mu zleca, tworząc jakieś fragmenty programu, ale nie może zastąpić osoby pracującej samodzielnie nad bardziej skomplikowanymi problemami. Oczywiście są wyjątki – bardzo dużo zależy od zdobytego doświadczenia w pracy zawodowej i od samodoskonalenia.

Wygląda na to, że wspomniani przez pana specjaliści z dziedziny cyberbezpieczeństwa muszą się ścigać z równie dobrze przygotowanymi hakerami, którzy nie tylko atakują prywatne konta bankowe czy profile w mediach społecznościowych, ale nawet mogą obezwładnić całe sieci i systemy strategiczne dla naszego życia.

– U nas prawo utrudnia działalność hakerów

b.tumilowicz@tygodnikprzeglad.pl

Atlas mózgu dla każdego

Pilotażowe Polskie Centrum Neurotechnologiczne miało być częścią Polskiego Technopolis – zalążkiem polskiej Doliny Krzemowej

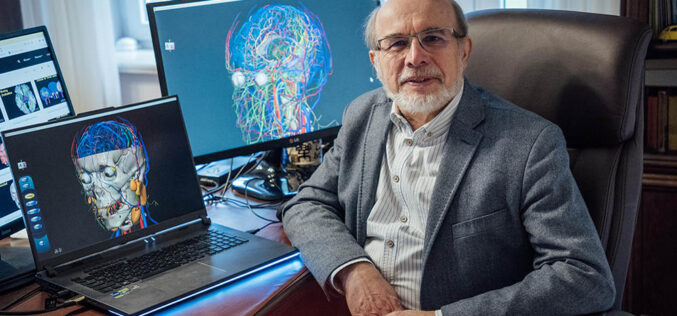

Prof. dr hab. inż. Wiesław Nowiński – informatyk, twórca 35 atlasów ludzkiego mózgu

Umawiając się na rozmowę, zastrzegł pan, że wolałby ograniczyć się do tematów technologicznych i nie poruszać medycznych. Tymczasem był pan uczestnikiem wielu kongresów medycznych, otrzymał wiele nagród od czołowych towarzystw medycznych, a w najnowszej edycji „Gray’s Anatomy” („Henry Gray’s anatomy of the human body”), zwanej biblią lekarzy, ma być zamieszczony rozdział o mózgu pana autorstwa i z obrazami pańskiego mózgu.

– Chciałbym uniknąć nieporozumień, ponieważ piszą do mnie osoby szukające ratunku dla swojego zdrowia. Medycyna nie jest moją wyuczoną specjalizacją, nie mam stopnia medycznego. A to, że anglojęzyczny podręcznik anatomii, który miał pierwsze wydanie w 1858 r. w Wielkiej Brytanii, zostanie uzupełniony rozdziałem wykorzystującym moje atlasy mózgu, jest wynikiem prac nad modelowaniem i wizualizacją tego organu oraz zapewne rozgłosu związanego z otrzymanymi przeze mnie prestiżowymi nagrodami, zarówno z dziedziny medycznej, jak ogólnonaukowej, radiologicznej, patentowej, wynalazczej itd.

Jak z perspektywy informatyka spogląda pan na ludzki mózg? Dostrzega pan w nim podobieństwa do komputera? Czy też odwrotnie – komputer stworzono na obraz i podobieństwo mózgu? I w końcu: czy komputer to maszyna myśląca?

– Podobieństwa są raczej dosyć odległe. Pierwsze modele komputerów były synchroniczne, a mózg jest asynchroniczny. Komputery mają procesory i pamięć. Jeśli chcemy wykonać w komputerze jakąś operację, to wiemy, gdzie to się dzieje. Tymczasem nie wiemy dokładnie, gdzie w mózgu zlokalizowana jest myśl. Pamięć RAM przechowuje informacje potrzebne do działania danego programu – bez niej żaden komputer nie będzie działać. A jak jest z naszą pamięcią, zapamiętywaniem i uczeniem się? Wiemy, że ważną rolę odgrywają synapsy czy połączenia między neuronami, ale w tej kwestii dysponujemy tylko hipotezami. Kolejne porównanie: mózg ludzki ma zapotrzebowanie energetyczne wielkości ok. 20 watów, natomiast największe i najsilniejsze komputery wymagają wielu megawatów i trzeba je chłodzić. Najpotężniejszy superkomputer w Europie, znajdujący się Finlandii, ogrzewa dzięki temu całe miasto. W obrazowaniu budowy mózgu nie osiągnęliśmy więc jeszcze doskonałości i odpowiedniej rozdzielczości: nasze modele czy mapy mózgu pokazują szczegóły wielkości do pół milimetra. Tymczasem gdyby zejść na poziom synaps mózgowych i neuronów całego mózgu ludzkiego, trzeba by ukazać obraz na poziomie nanometrów. Jak takie obrazowanie przetwarzać we współczesnych komputerach? Potrzebne byłyby jakieś niewiarygodnie wydajne maszyny. Dziś mamy problemy z obrazowaniem działania mózgu muszki owocowej Drosophila melanogaster, który ma 100-130 tys. neuronów. Mózg człowieka zawiera zapewne ok. 86 mld neuronów i policzono, że do jego pełnego zobrazowania, stosując metody pracy takie same jak dla muszki owocowej, potrzebowalibyśmy 17 mln lat!

Jednak się nie poddajemy – powstają coraz lepsze, dokładniejsze, bardziej wyrafinowane i wyspecjalizowane atlasy mózgu oraz jego części.

– Tak, postęp jest nadzwyczajny. Niczego jednak nie da się zrobić bez zaplecza finansowego i ludzkiego. Myślę, że rozsądnym praktycznym rozwiązaniem jest komercjalizacja tego,

Świat pełen kalendarzy

Czyli jak liczymy czas

Dlaczego w 1582 r. czas gwałtownie przyśpieszył? Ano dlatego, że 10 dni w jego otchłani bezpowrotnie zaprzepaścił papież Grzegorz XIII. Najwyższy hierarcha Kościoła przeraził się, że na Wielkanoc w Rzymie spadnie śnieg. Dlatego postanowił „naprawić” kalendarz zwany juliańskim (od cesarza rzymskiego Juliusza Cezara, obowiązujący od roku 46 p.n.e.) i wyrzucił z niego 10 dni. To wtedy po czwartku 4 października, nastał piątek 15 października.

„Szczególnie wściekli byli wierzyciele, bo nie wiedzieli, jak liczyć odsetki dłużnikom”, napisał, przypominając tę ciekawostkę, Paweł Łepkowski w dzienniku „Rzeczpospolita” (4 października 2024). Za to lichwiarze doliczali sobie procent za dni, których nie było. Jak później się okazało, z kalendarza trzeba było wykreślić nie 10, ale 14 dni, by trafił we właściwe koryto czasu. Nasz obecny kalendarz też nie jest idealny: są w nim miesiące mające 30 i 31 dni, a co cztery lata dodajemy w lutym dodatkową dobę. Jednak podobne akrobacje jak ta z przejściem z kalendarza juliańskiego na gregoriański już później nie miały miejsca.

Czas ciągle się „psuje”

Liczenie czasu zaczęło się od pojęcia dnia albo doby. Po nim następował tydzień i miesiąc, których regularność wyznaczały cztery kwadry księżyca, a także np. cykl menstruacyjny kobiety. Młodszym pojęciem jest godzina. 12 godzin dziennych i nocnych wzięło się z dwunastkowego systemu liczbowego używanego w Babilonii – do 12 można było bowiem policzyć na palcach dwóch rąk – dodatkowo doliczano zaciśniętą pięść. Ślady porządku dwunastkowego widać w wielu systemach miar: rzymski as to 12 uncji, europejski solid to 12 denarów, brytyjski szyling – 12 pensów, stopa – 12 cali.

Dosyć szybko zauważono także regularność ruchu Księżyca i jego wpływ na przyrodę. Satelita posłużył do stworzenia jednostki czasu zwanej miesiącem. Znamy to np. z Biblii: „Tyś stworzył Księżyc, aby czas wskazywał” (Ps 104,19), a jedna z Mądrości Syracha brzmi: „Księżyc też świeci zawsze w swojej porze, aby ustalać czas i być wiecznym znakiem” (Syr 43,6). Tutaj jednak zaczynają się problemy, ponieważ miesiąc trwa średnio 29,53 doby (dokładnie 29 dób, 12 godzin, 44 minuty, 3 sekundy). Co zrobić z resztą? Mało kto również się orientuje, że np. w naszej sytuacji czasowej wciąż coś się „psuje”, doba otrzymuje dodatkowe sekundy i być może za kilka lat trzeba będzie znowu dokonać korekty w stylu papieża Grzegorza XIII. Przykłady? Ktoś wyliczył, że za 1000 lat

grudzień znalazłby się w środku lata, niezależnie od ocieplenia klimatu. Doba zmieniła się lekko także po największym tsunami azjatyckim w 2004 r. Wielki wstrząs tektoniczny wpłynął na obrót Ziemi. Niektóre modele teoretyczne sugerują, że doba została skrócona o 3 milionowe części sekundy (3 mikrosekundy). Tymczasem siły pływowe Księżyca wydłużają okres obrotu Ziemi o całe 15 mikrosekund w ciągu roku. W ciągu trzech miesięcy po tsunami doba powróciła do swojej poprzedniej długości. Wstrząs wywołał przesunięcie osi Ziemi o 2,5 cm (przesunęły się też niektóre małe wyspy). Należy poza tym zaznaczyć, że naturalne ruchy osi Ziemi mogą wynosić nawet 15 m.

Każdy chciałby liczyć po swojemu

Wróćmy do kalendarzy. W gregoriańskim będziemy teraz mieli rok 2025 – lata liczymy od hipotetycznego narodzenia Chrystusa. Data Bożego Narodzenia została jednak wstawiona do kalendarza nie jako rzeczywista rocznica, ale wedle jej znaczenia symbolicznego. Około 24 grudnia zostaje bowiem przełamane skracanie się długości dnia i zwycięża jasność.

W kalendarzu żydowskim będziemy mieli rok 5785 – tutaj liczymy od dnia stworzenia świata. Według ustaleń żydowskich autorytetów religijnych nastąpiło to 7 października 3761 p.n.e. W rozkładzie miesięcy i dni również mamy niewielkie różnice. Rok hebrajski dzieli się na 12 miesięcy liczących 29 lub 30 dni. Ponadto co trzy, rzadziej co dwa lata dla zrównania cyklu solarnego z lunarnym dodawany jest dodatkowy, 13. miesiąc, zwany adar szeni. Nowy rok może nadejść tylko w dzień stworzenia Adama przez Boga

Milion i pół kilometra od Ziemi

Co nam daje teleskop Jamesa Webba?

Prof. Paweł Pietrukowicz – astronom, członek zespołu OGLE (The Optical Gravitational Lensing Experiment) przy Obserwatorium Astronomicznym UW.

Nasz nowy teleskop – nasz, bo jest on własnością NASA (USA), ESA (Europa) i CSA (Kanada), a także Polski, skoro płacimy składkę za członkostwo w Europejskiej Agencji Kosmicznej – kosztował 10 mld dol. Właśnie ten koszt był przyczyną opóźnień w jego uruchomieniu. Stało się to możliwe dopiero 25 grudnia 2021 r. Jednak skorzystać z niego można było po pół roku – tyle zajęło złożenie lustra i przetestowanie. Efektywnie pracuje od lipca 2022 r.

– Sprecyzujmy. Nie było żadnego polskiego wkładu w budowę teleskopu Webba. Europejska rakieta wystartowała z Gujany. Przygotowania do powstania teleskopu trwały dwie dekady. Jeśli chodzi o udział Polski, to moja była studentka Aleksandra Hamanowicz pracuje w instytucji nadzorującej Space Telescope Science Institute, mającego siedzibę w Baltimore koło Waszyngtonu.

Teleskop Webba jest kolejnym, po teleskopie Hubble’a, przedsięwzięciem „przedłużającym” nasze zdolności obserwowania nieba.

– Hubble, pracujący od 1990 r., został umieszczony na orbicie na wysokości 600 km nad Ziemią. Do tej pory odbyło się pięć misji serwisowych. Napraw dokonywali astronauci. Najczęściej psuły się żyroskopy odpowiadające za stabilizację urządzenia. Obecnie, gdy nie ma już lotów wahadłowców, jego stan się pogarsza. Jeszcze pracuje, ale jest bliski zamknięcia. Koordynacją i nadzorem zajmuje się ten sam Space Telescope Science Institute. Teleskop Webba nie okrąża Ziemi. Został wyniesiony do punktu L2, w którym równoważy się przyciąganie Ziemi i Słońca. To cztery razy dalej niż odległość Księżyca od Ziemi. Krąży wokół Słońca wraz z Ziemią. Hubble ma detektory optyczne, Webb zaś działa na podczerwień, co pozwala zobaczyć więcej i dalej, bo przesyłany przez niego obraz pozwala przedrzeć się przez obłoki pyłu. Dzięki temu możemy obserwować, jak z obłoków gazowo-pyłowych formują się planety i gwiazdy. To jeden z dwóch głównych celów badawczych teleskopu Webba. W podczerwieni widać odleglejsze rejony wszechświata.

Teleskop Hubble’a nie mógł odbierać fal podczerwieni?

– Jego kamery rejestrowały pełny obraz światła widzialnego, natomiast kamery i spektrografy reagujące na podczerwień mają taką cechę, że muszą być odpowiednio schłodzone. Do tej pory podobne urządzenia w przestrzeni kosmicznej schładzano ciekłym helem, ale to paliwo wyczerpywało się po jakichś dwóch latach. Chodzi o schłodzenie do bardzo niskiej temperatury, 50 K, czyli minus 223 st. C. Tego nie stosuje się w teleskopie Webba. Do zasłonięcia urządzenia przed światłem słonecznym zastosowano tarczę odbijającą promieniowanie słoneczne. Teleskop znajdujący się w cieniu ochładza się w przestrzeni międzyplanetarnej w sposób naturalny do minus 223 st. C.

Nie grozi mu np. to, że odwróci się do Słońca niezasłoniętą stroną?

– Nie ma takiego zagrożenia, a nawet gdyby jego ustawienie zaczęło się zmieniać, niewielkie silniczki, w które jest wyposażony, dokonają korekty. Jest to jak dotychczas największe urządzenie tego typu wysłane przez człowieka w kosmos. I najdroższe. Ma 6,5 m średnicy. Na cenę miały wpływ rodzaj materiału i dokładność wykonania. Jego zwierciadło zbudowano z berylu, który jest bardzo lekki. Powierzchnia odbijająca światło pokryta jest warstwą złota. Planowany czas działania to 10 lat.

Czego możemy się dowiedzieć przez ten czas?

– Cele naukowe przedsięwzięcia są bardzo ambitne. Możemy poznać sposób formowania się wszechświata niedługo po Wielkim Wybuchu. To moment, który według obliczeń nastąpił dokładnie 13,8 mld lat temu.

Skarby w pancernych gablotach

Od „Rocznika świętokrzyskiego” do „Rozmów z katem”

Dr Tomasz Makowski – dyrektor Biblioteki Narodowej

Najwyraźniej lubi pan oprowadzać po wystawie stałej w odnowionym i otwartym dla zwiedzających Pałacu Rzeczypospolitej. Specjalnie zaaranżowana w kilku salach ekspozycja, czynna już od czterech miesięcy, przedstawia 170 najcenniejszych, unikatowych obiektów ze skarbca narodowej książnicy. Są to zabytki polskiego i światowego piśmiennictwa, począwszy od VIII w. aż po czasy współczesne. Czy sprawdził się pomysł, aby udostępnić te dzieła bezpłatnie wszystkim chętnym?

– Z pewnością. Świadczy o tym liczba zwiedzających, która już przekroczyła 70 tys. Codziennie, prócz wtorków, widzimy tutaj ludzi ogromnie zainteresowanych tymi skarbami, świadczącymi o naszej historii od zarania dziejów polskiej państwowości, poprzez kolejne wieki, także w czasach utraty niepodległości, aż do najwybitniejszych dokumentów kultury współczesnej.

Ułożenie udostępnionych eksponatów wymagało przyjęcia jakiegoś klucza.

– Klucz jest prosty. Ekspozycja ma układ chronologiczny. Otwiera ją najstarszy zabytek polskiej historiografii – „Rocznik świętokrzyski dawny”, w którym zostało zapisane zdanie: „Dubrovka venit ad Miskonem” (Dąbrówka przybyła do Mieszka), kończy zaś rękopis „Przesłania Pana Cogito” Zbigniewa Herberta z wymowną frazą „Bądź wierny. Idź”, sporządzony przez poetę w niewielkim zeszyciku drobnymi literkami.

Nawet najciekawsze druki czy rękopisy w gablotach same w sobie mogą wielu odwiedzających znudzić. Przydałyby się więc jakieś anegdoty z nimi związane czy wręcz dowcipy.

– Oprowadzający mają w zanadrzu wiele takich opowieści. Ale można je usłyszeć także w audioprzewodniku. A co do gablot, warto wiedzieć, że wszystkie są pancerne i podłączone do elektronicznej sieci monitoringu. Strażnicy nie muszą więc obserwować odwiedzających na miejscu, bo sygnał o jakimś zagrożeniu powoduje, że w sali od razu pojawia się ochrona z bronią.

Tego lepiej nie testować.

Które eksponaty są najcenniejsze?

– W pierwszej gablocie, gdzie znajdują się najstarsze księgi, po prawej stronie spoczywa „Rocznik świętokrzyski” otwarty właśnie na stronie, gdzie jest mowa o Dąbrówce, która przybyła do polskiego władcy Mieszka I. A obok znajdują się kroniki Galla Anonima, Wincentego Kadłubka i Jana Długosza. Gablota zawierająca tak znaczące dokumenty z początków naszej państwowości jest celowo umieszczona niziutko, aby z łatwością mogły tam zajrzeć dzieci i np. osoby na wózkach.

Inne gabloty są wyższe.

Jak nie zaszkodzić polskiej nauce?

Minister Wieczorek powinien otoczyć się kompetentnymi, obiektywnymi osobami, odsuwając na boczny tor zwolenników kolejnej manipulacji punktami

Przeciętny czytelnik czy odbiorca programów informacyjnych nie orientuje się w szczegółach problemów, z jakimi boryka się polska nauka. Docierają do niego jakieś newsy o skandalach z przyznawaniem środków finansowych i kupowaniem dyplomów, o plagiatach i aferach obyczajowych, rzadziej – o sukcesach, odkryciach czy wynalazkach. Tymczasem życie naukowca w obecnych warunkach prawnych i organizacyjnych to także ciągła walka np. z nieuczciwą konkurencją, perfidnym oszustwem, manipulacją i innymi absurdami, stworzonymi na różnych etapach przez tzw. czynniki decyzyjne, czyli naszych polityków.

Punktoza a sprawa polska

– Jestem stanowczym przeciwnikiem punktozy w ocenianiu rangi czasopism naukowych – mówi prof. Daniel Młocicki, parazytolog z Warszawskiego Uniwersytetu Medycznego, a przy tym redaktor naczelny specjalistycznego kwartalnika „Acta Parasitologica”, uwzględnianego we wszystkich liczących się bazach i posiadającego tzw. współczynnik wpływu (impact factor).

Rzecz dotyczy postępującej patologii w naszym nieco zaściankowym „obrocie myśli naukowej”. Przez kilka lat prof. Młocicki koordynował działalność Editors Clubu WUM, na spotkaniach którego piętnowano ową punktozę i który wysyłał do ministerstwa liczne protesty przeciwko fali destrukcji spowodowanej woluntarystycznym, zdecydowanie nieuczciwym promowaniem wydawnictw publikujących naukową lichotę.

A kto jest autorem takiego systemu dowolnego windowania niektórych uczelni, instytutów badawczych czy zespołów naukowych? Tu padają nazwiska byłych ministrów nauki: Jarosława Gowina i Przemysława Czarnka.

Manipulacja ewaluacją

Pierwsze punkty pojawiły się jeszcze za kadencji minister Barbary Kudryckiej. Później zmiany legislacyjne wprowadzone przez ministra Gowina sprawiły, że punktacja publikacji w czasopismach odeszła od obiektywnych kryteriów opartych na wskaźnikach bibliometrycznych. W przypadku pracownika nauki ważna jest np. liczba publikacji naukowych w prestiżowych lub specjalistycznych czasopismach posiadających impact factor, liczba cytowań, liczba patentów oraz inne wskaźniki. U nas jednak zaczęto przyznawać punkty według niejasnych kryteriów popartych tylko siłą przebicia czy protekcją osoby decyzyjnej.

– Gdyby rangę wydawnictwa czy pojedynczej publikacji wyznaczały znane powszechnie parametry bibliometryczne, nie miałoby sensu angażowanie ministra i powoływanie dodatkowych gremiów, bo są to parametry obiektywne, które mógłby wykorzystać odpowiedni urzędnik resortu – kontynuuje swój wywód prof. Młocicki i ubolewa, że prowadzony przez niego anglojęzyczny, uznany w świecie nauki kwartalnik, w radzie którego są głównie znani badacze zagraniczni, uzyskał tyle samo punktów, co jakieś niszowe czasopismo, niekiedy niemal podwórkowe, wydawane po polsku, ale mające przychylność aktualnej władzy.

Publikacja na łamach prestiżowego czasopisma jest miarą jakości pracy naukowca. I nie tylko względy ambicjonalne powodują niesmak związany z punktozą. Za odpowiednio wysoką ewaluacją stoją spore pieniądze. A to już zakrawa na szwindel, bo to nierzadko środki publiczne, niezbyt hojnie dozowane.

Mechanizm sztucznego windowania osiągnięć naukowych, a przy tym nabijania kabzy wpływowym korporacjom nieakademickim, które w nauce dostrzegły szansę na świetny biznes, jest dosyć skomplikowany. Najbardziej jednak drażnią pracowników nauki „ręcznie sterowane” punkty przyznawane określonym czasopismom. Tworzy się w ten sposób patologia, bo autor, instytut czy uczelnia walczą o punkty, a nie o poziom obiektywnie wyznaczony na podstawie parametrów bibliometrycznych. Obecny system prowadzi do budowania polskiej nauki na grząskim piasku, zamiast na solidnych fundamentach stosowanych przez cały cywilizowany świat.

Jak w Biblii, ostatni będą pierwszymi

O tym, jak jest na świecie, mówi prof. dr hab. inż. Wojciech Piasecki z Instytutu Nauk o Morzu i Środowisku Uniwersytetu Szczecińskiego – wcześniej postdoc w Kanadzie i USA (przez trzy lata) – redaktor naczelny „Acta Ichthyologica et Piscatoria”.

b.tumilowicz@tygodnikprzeglad.pl